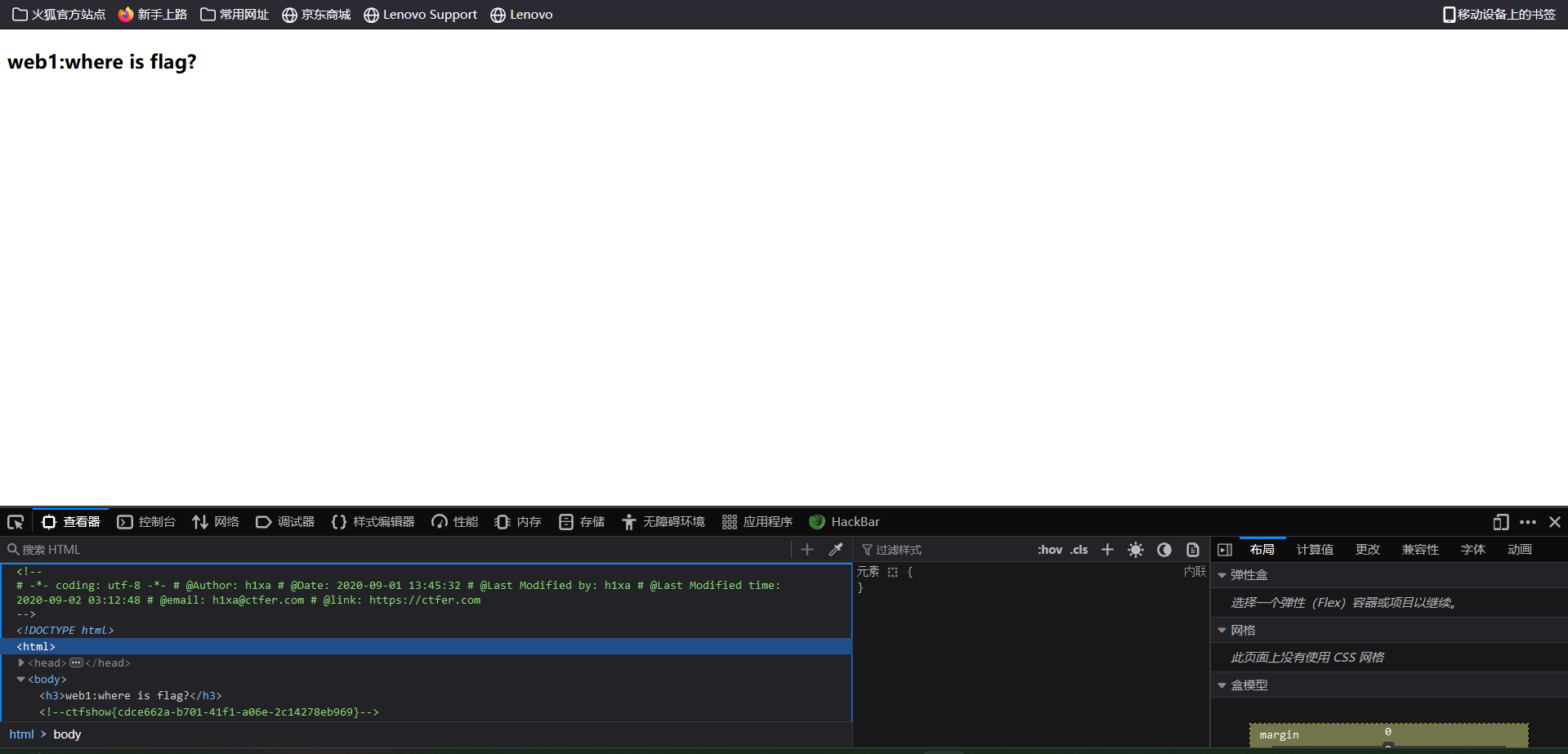

1,查看源代码

2,按F12

3.在URL前面加view-source

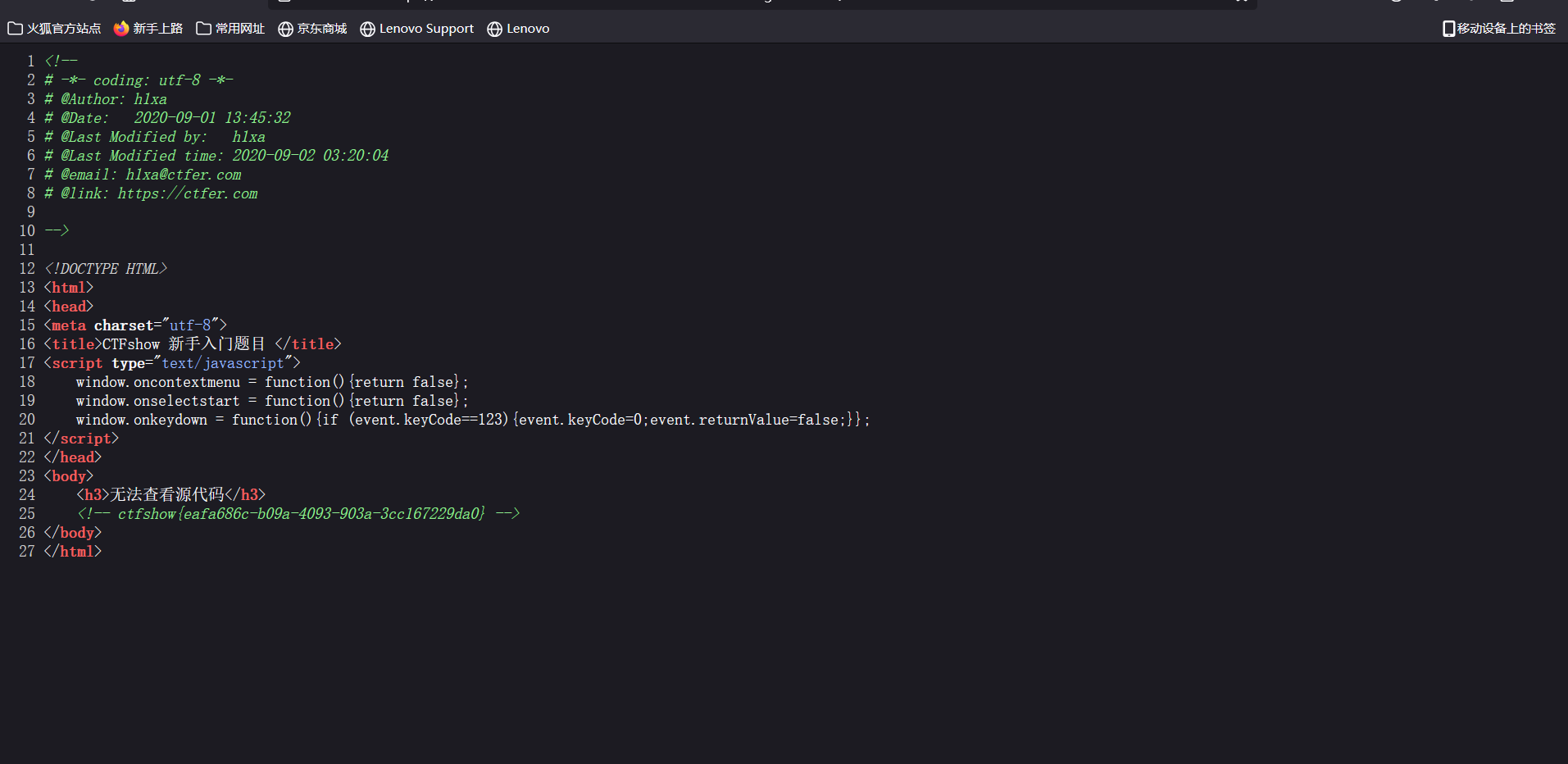

2.右键无法查看源代码,按F12也无法响应,按ctrl加u或者在URL前面加View-source]

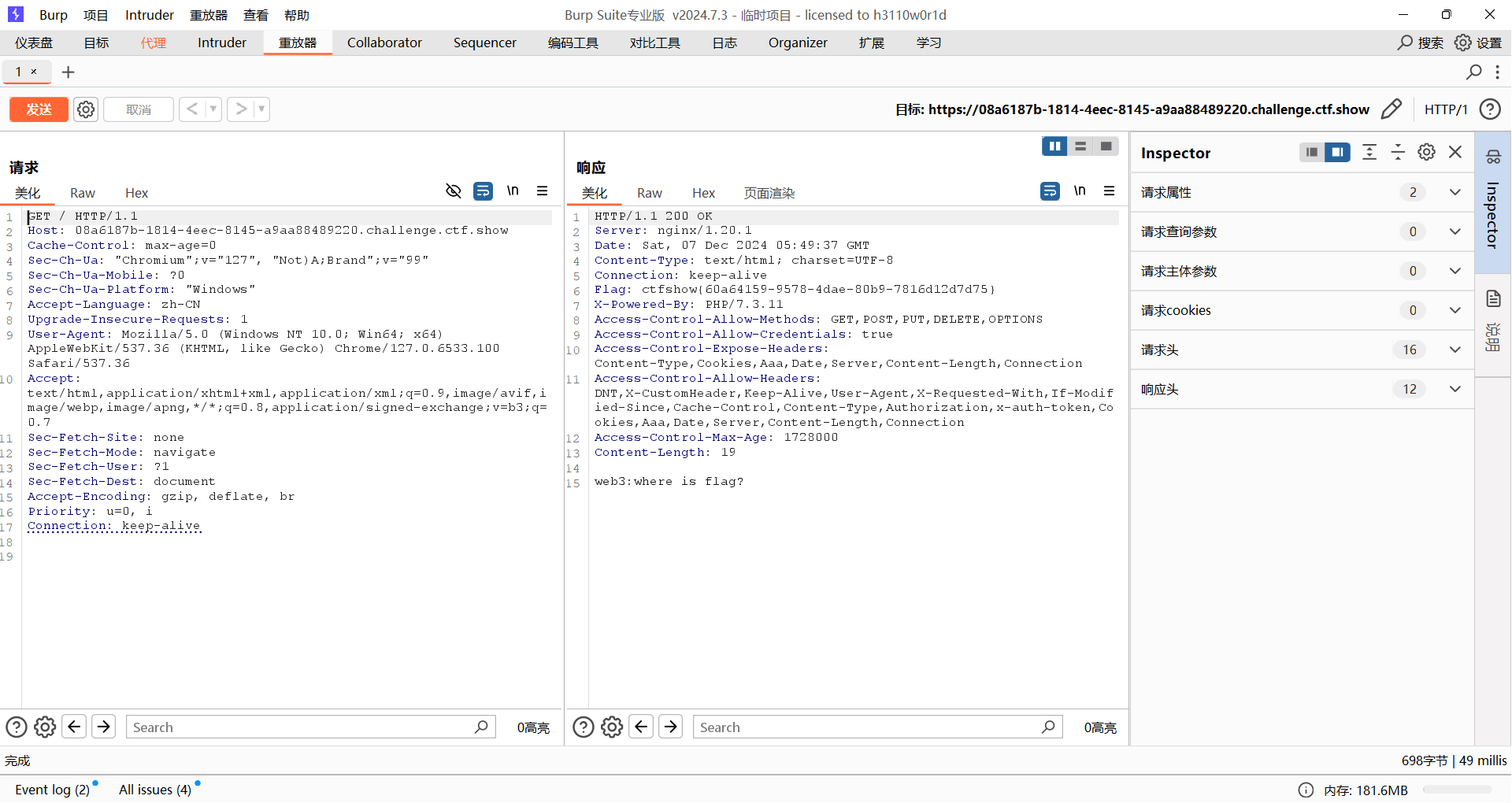

3.题目提示抓包,进行抓包后重新发包

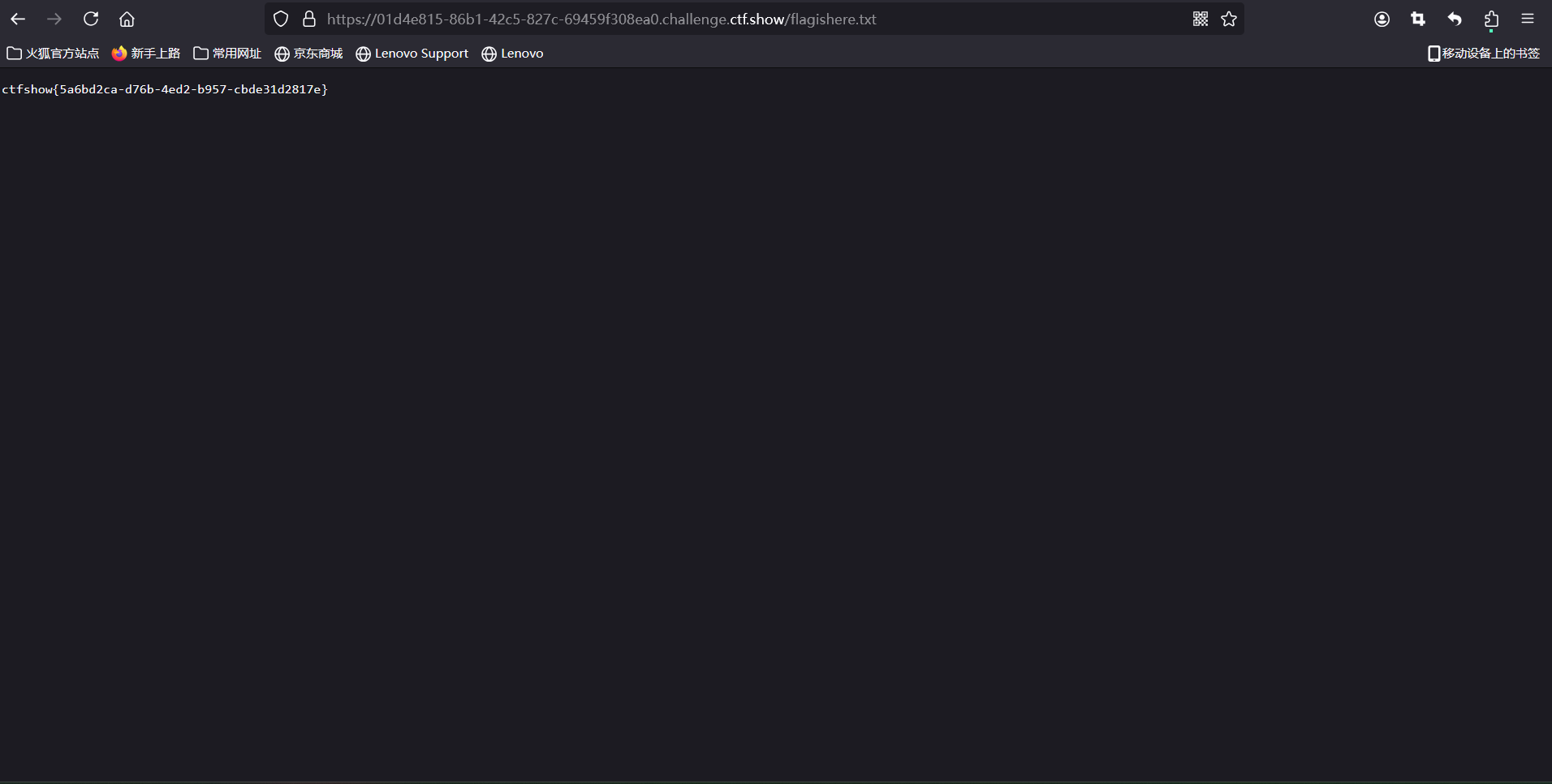

4.Robot协议"通常是指与网页爬虫和搜索引擎相关的协议,尤其是"robots.txt"文件。这个文件用于告诉爬虫哪些部分的网站可以被访问,哪些部分不能被访问。这是一种标准的协议,旨在保护网站的隐私和资源。robots.txt 文件的基本结构

一个基本的 robots.txt 文件的示例如下:

User-agent: *

Disallow: /private/

Allow: /public/

User-agent:指定哪个搜索引擎的爬虫适用于该规则。* 表示所有爬虫。

Disallow:后面跟着的路径是不允许爬虫访问的部分。

Allow:后面跟着的路径是允许爬虫访问的部分。

查看网站robots协议的方法:

在网站的域名后面加 /robots.txt

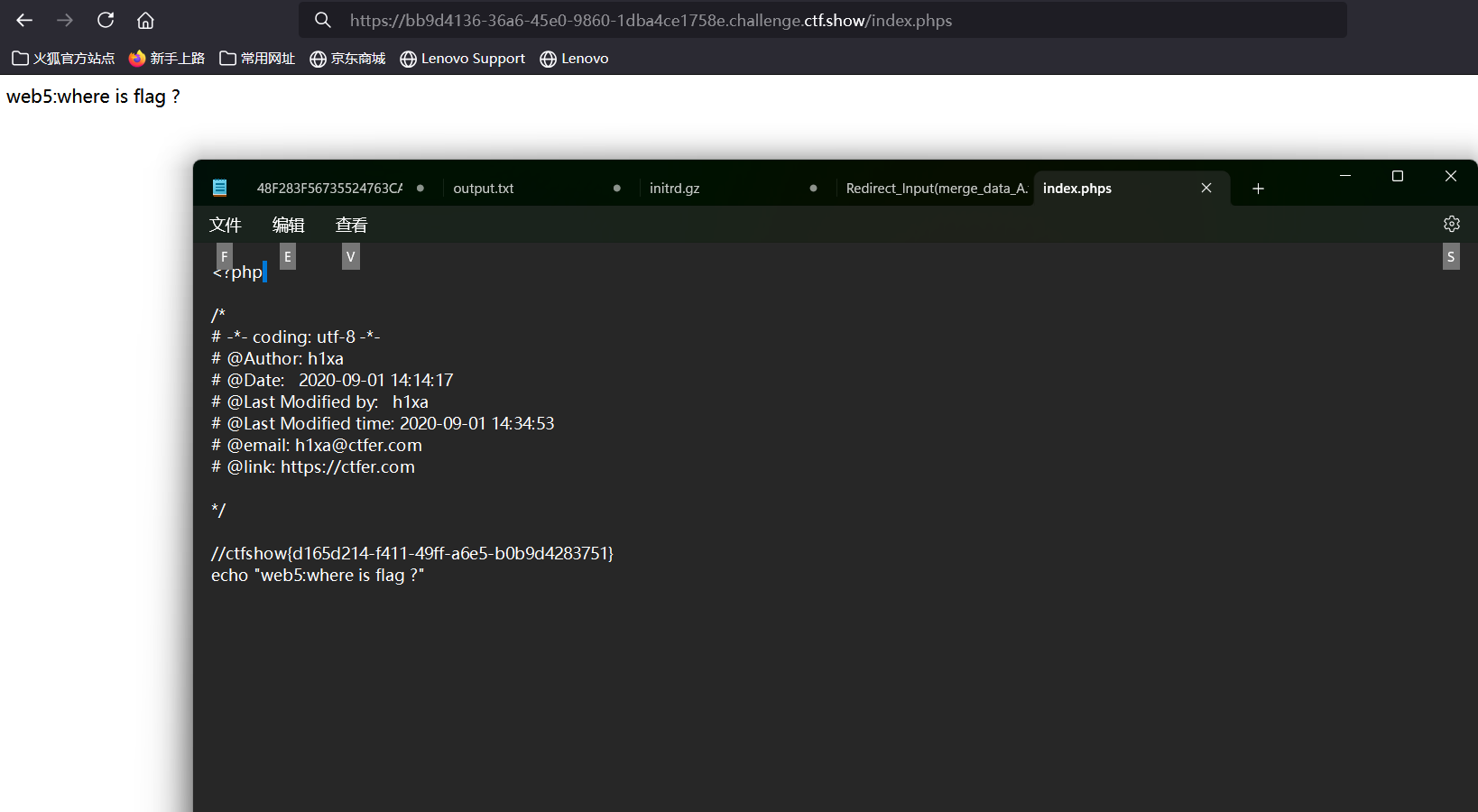

5.phps文件泄露,phps存放着php源码,可通过尝试访问/index.phps读取,或者尝试扫描工具扫描读取.

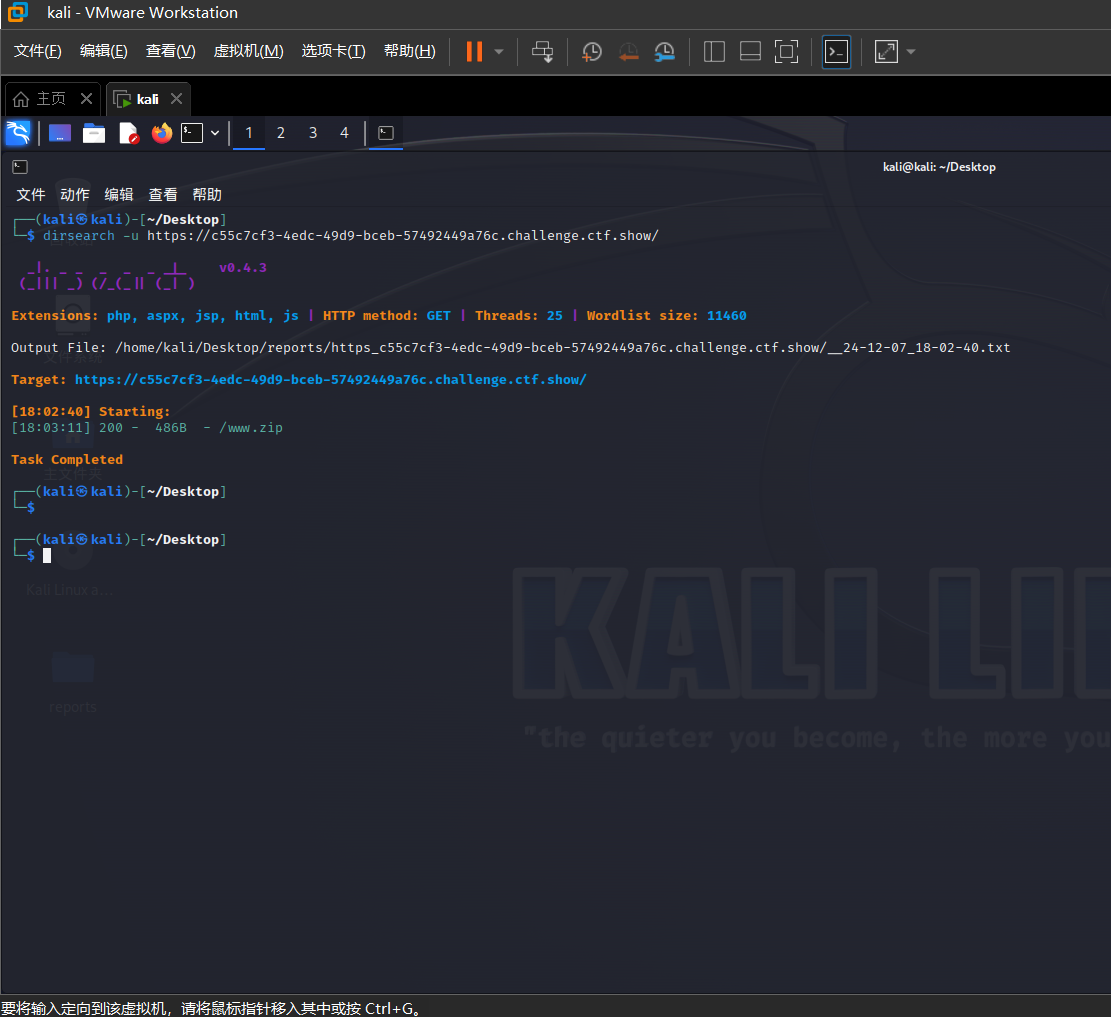

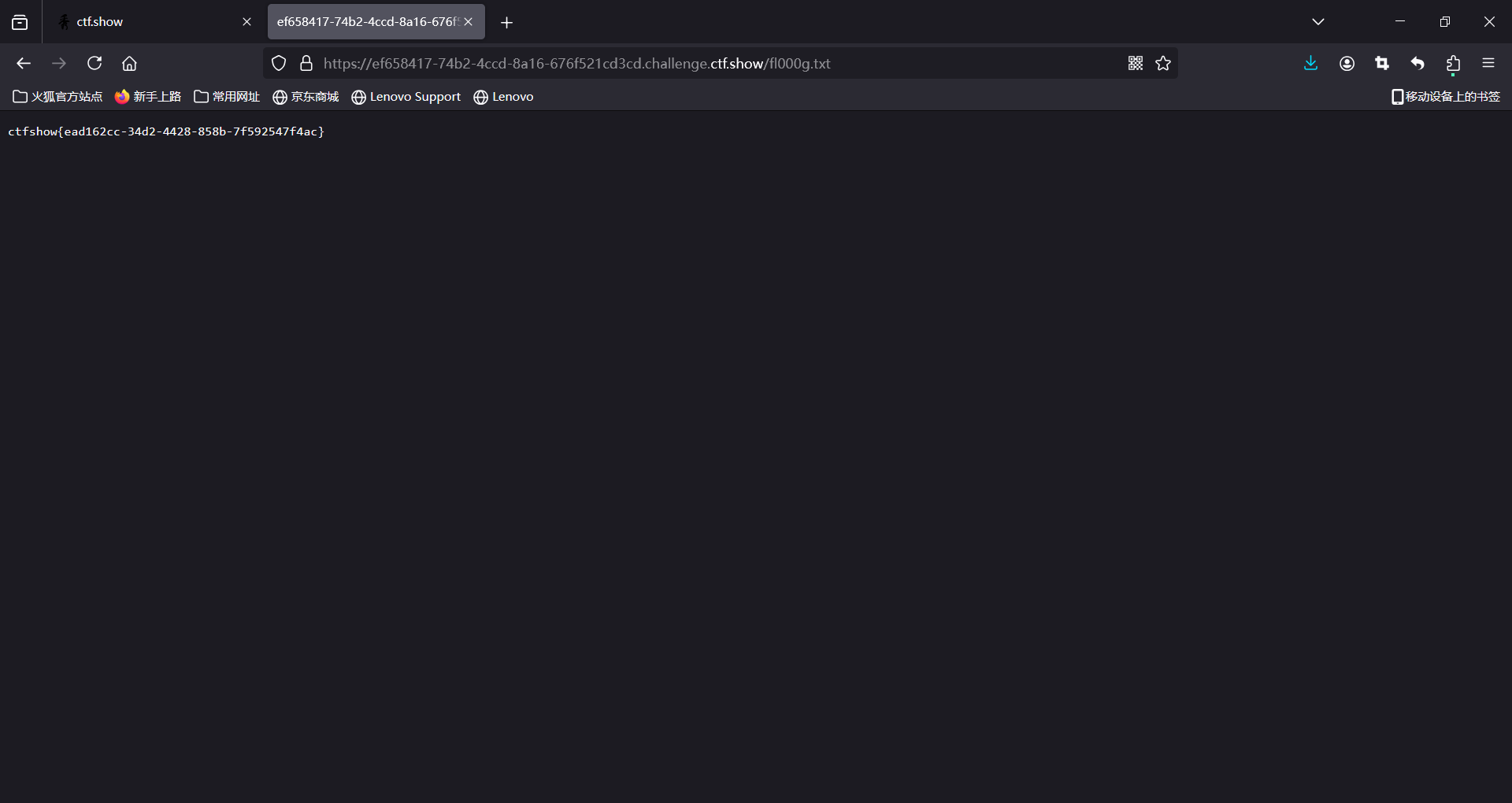

6.用dirsearch扫描,访问/www.zip

在网站的升级和维护过程中,通常需要对网站中的文件进行修改。此时就需要对网站整站或者其中某一页面进行备份。

当备份文件或者修改过程中的缓存文件因为各种原因而被留在网站 web 目录下,而该目录又没有设置访问权限时,便有可能导致备份文件或者编辑器的缓存文件被下载,导致敏感信息泄露,给服务器的安全埋下隐患。

该漏洞的成因主要有是管理员将备份文件放在到 web 服务器可以访问的目录下。

该漏洞往往会导致服务器整站源代码或者部分页面的源代码被下载,利用。源代码中所包含的各类敏感信息,如服务器数据库连接信息,服务器配置信息等会因此而泄露,造成巨大的损失。

被泄露的源代码还可能会被用于代码审计,进一步利用而对整个系统的安全埋下隐患。

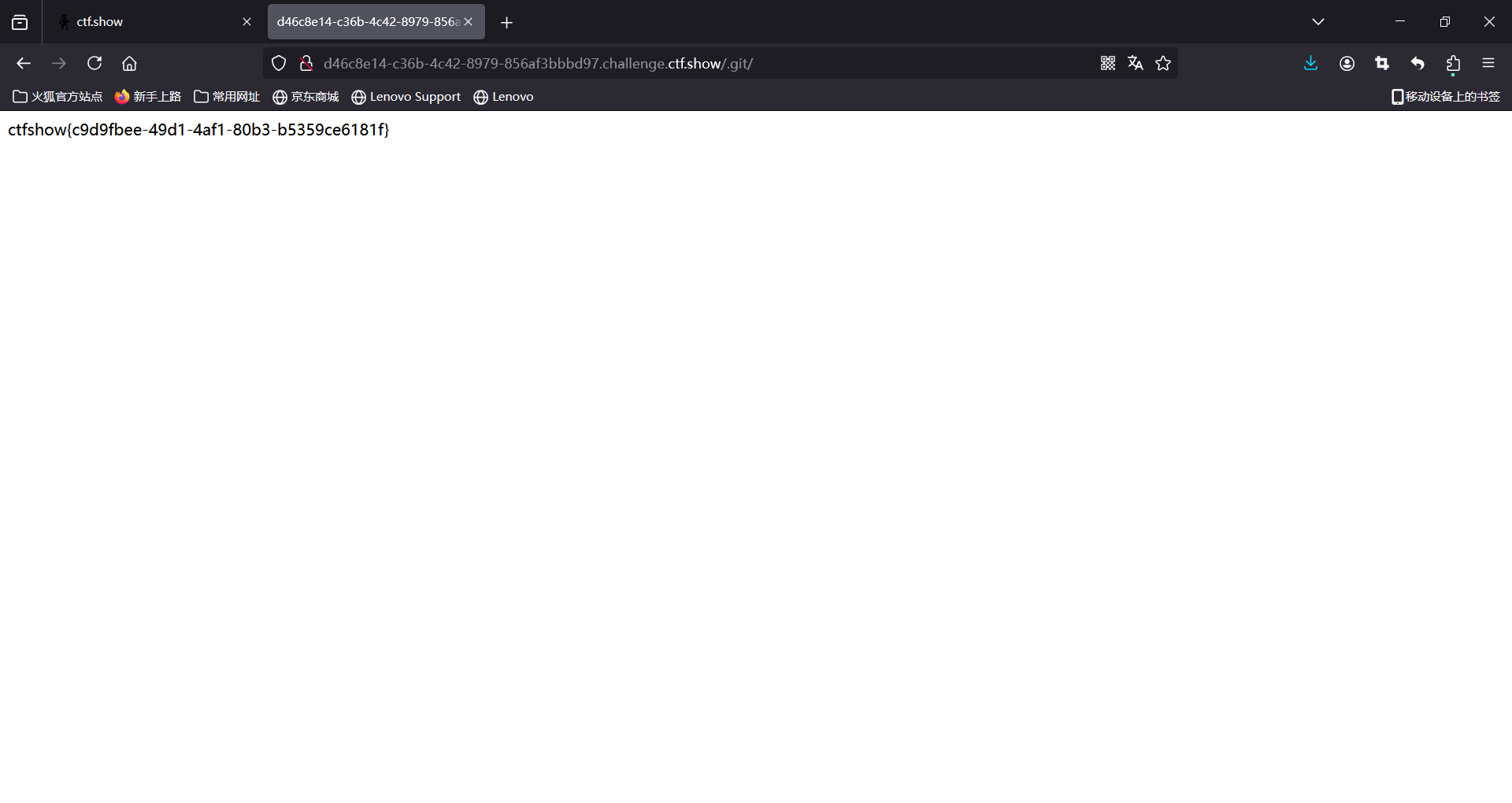

7.版本控制(Revision control)是一种在开发的过程中用于管理我们对文件、目录或工程等内容的修改历史,方便查看更改历史记录,备份以便恢复以前的版本的软件工程技术。简单来说就是用于管理多人协同开发项目的技术。没有进行版本控制或者版本控制本身缺乏正确的流程管理,在软件开发过程中将会引入很多问题,如软件代码的一致性、软件内容的冗余、软件过程的事物性、软件开发过程中的并发性、软件源代码的安全性,以及软件的整合等问题。总结:Git是目前世界上最先进的分布式版本控制系统。

访问.git就可以直接重定向到.git/index.php

或者直接访问.git/index.php

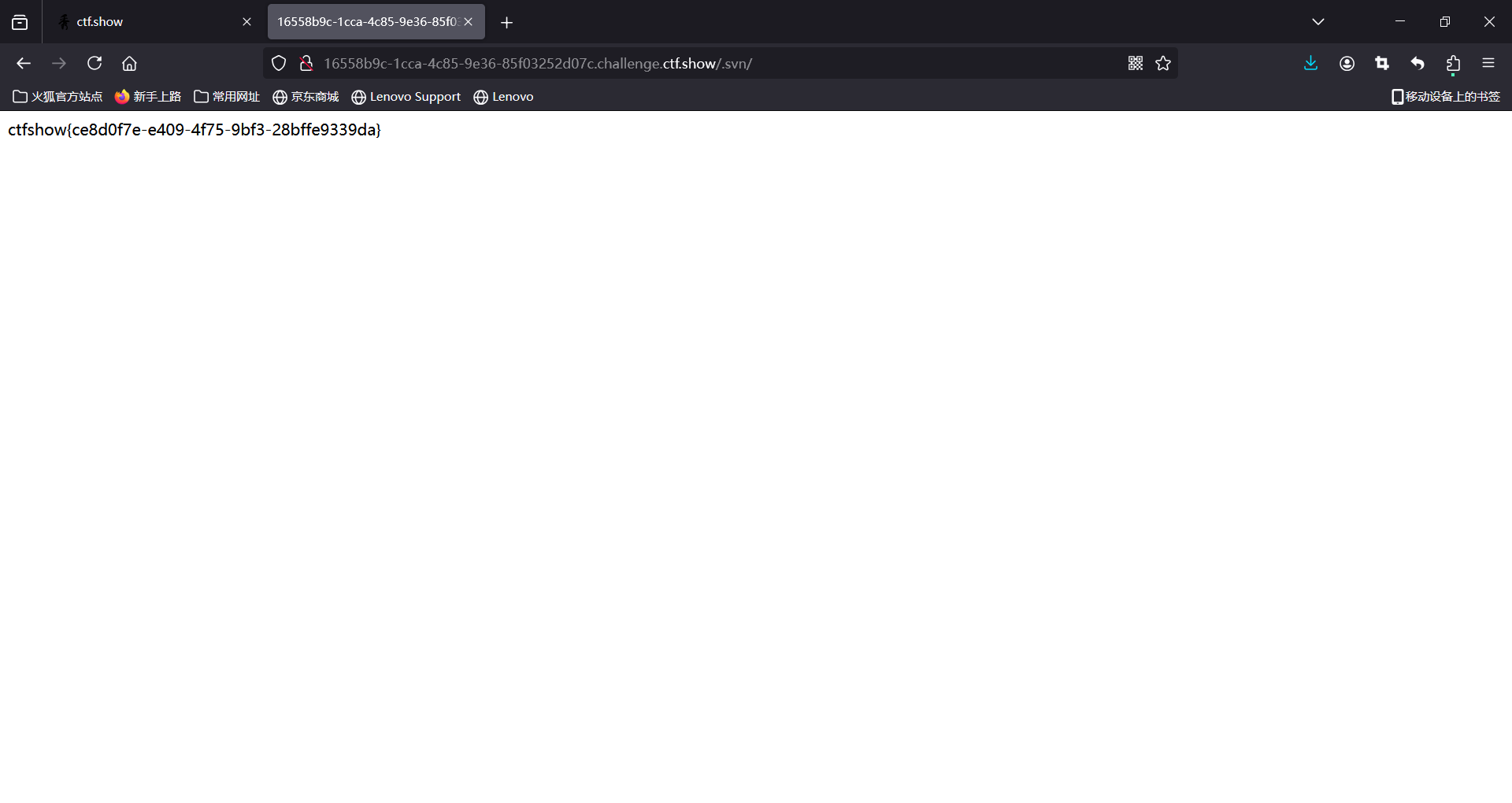

8,和7的做法一样

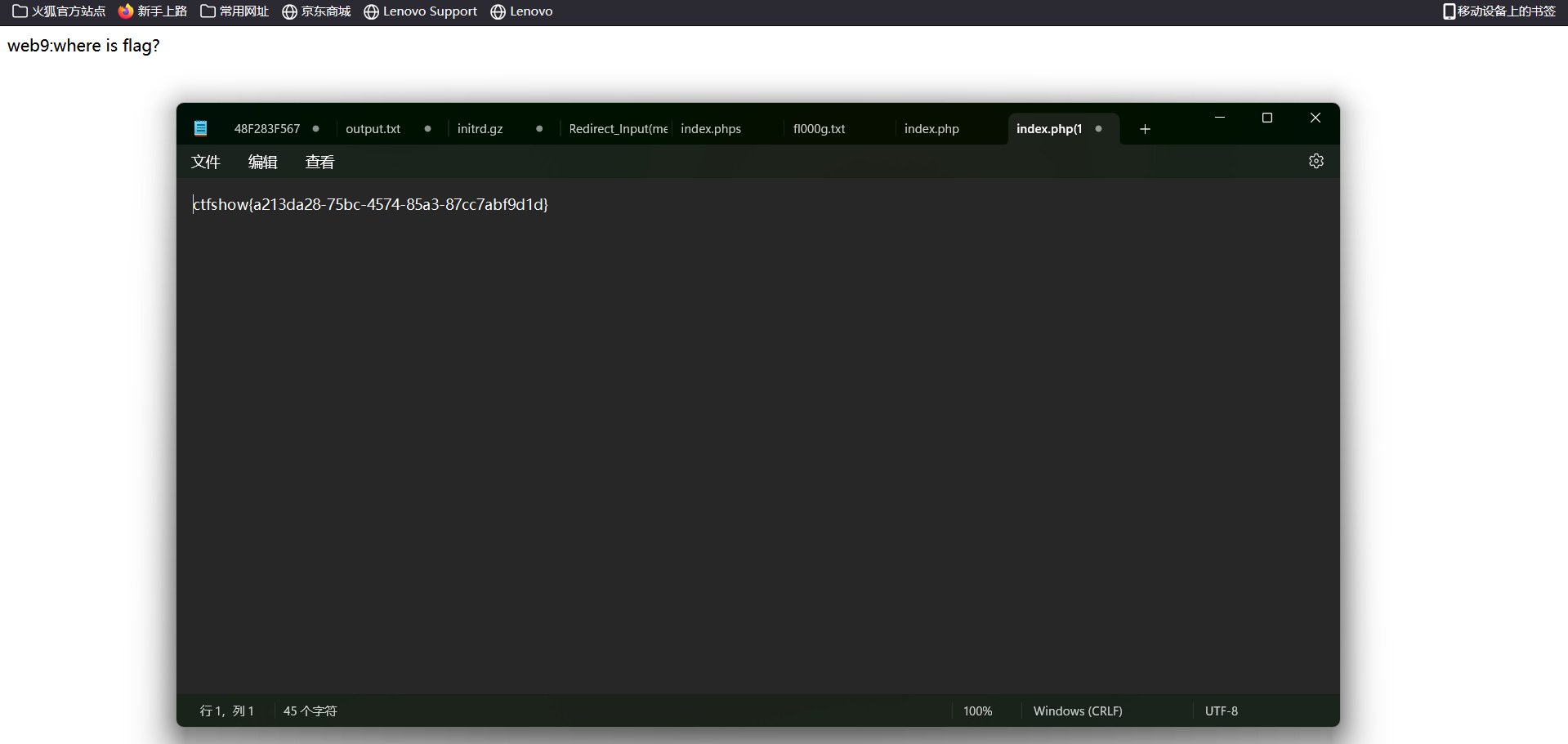

9,当开发人员在线上环境中使用 vim 编辑器,在使用过程中会留下 vim 编辑器缓存,当vim异常退出时,缓存会一直留在服务器上,引起网站源码泄露。

获取环境后提示flag在index.php的源码中,结合提示下载.index.php.swp文件,后在下载目录下打开终端利用`

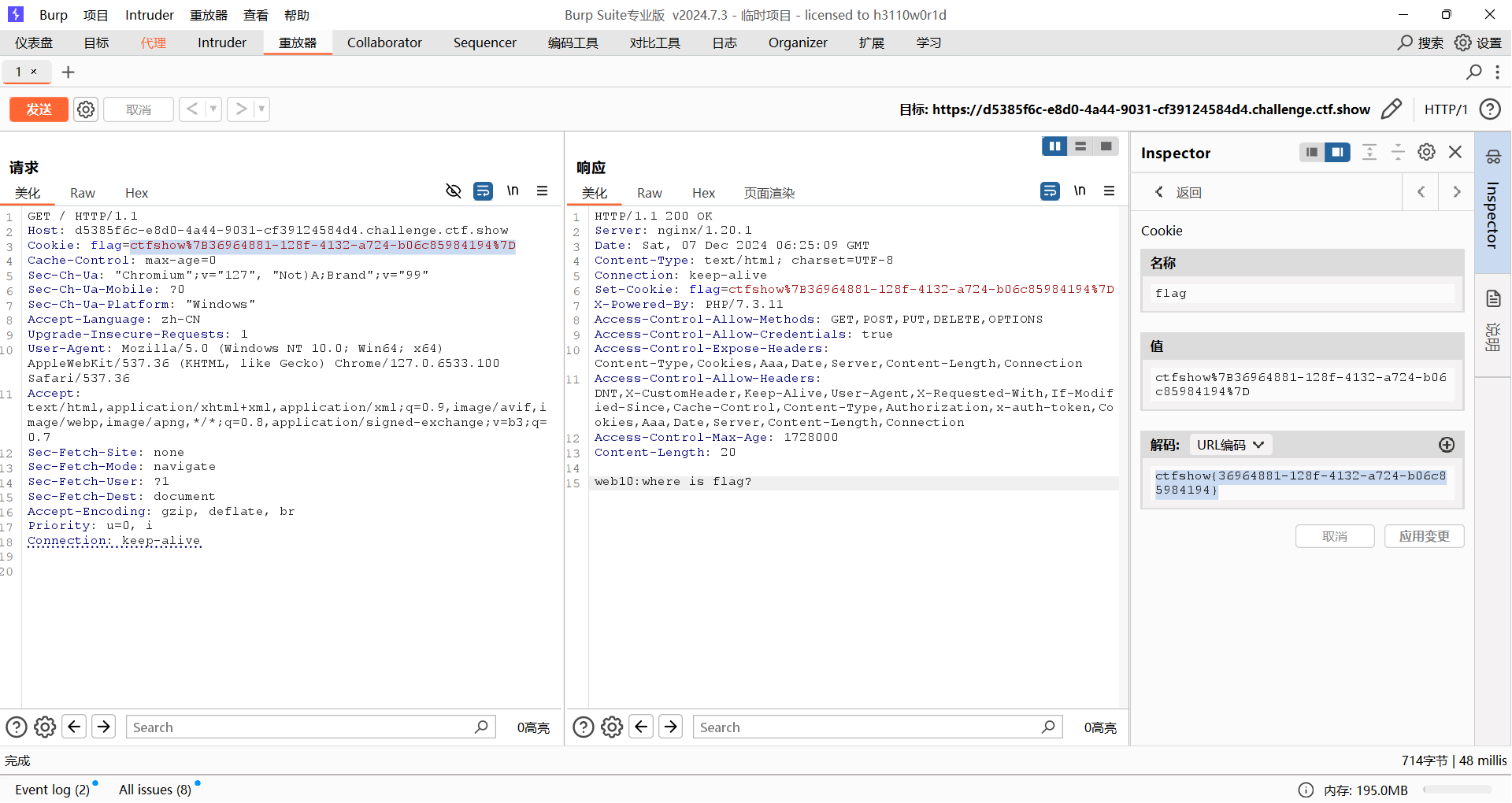

10.提示cookie直接进行抓包